发布日期:2025-02-28 05:34 点击次数:70

【大河财立方音尘】2月5日九游体育娱乐网,中信建投发布DeepSeek中枢十问十答。

中信建投研报称,DeepSeek-R1模子发布,具有高性能、低算力需求的脾气,带动小模子推理才智的扶助,激发大家开发者及用户眷注。R1行动开源模子性能接近头部闭源模子o1,一定程度上已经反应了AI平权,同期纯强化学习对推理才智的扶助带来RL范式泛化可能,瞻望后续基模的捏续迭代,有望推动AI全产业链捏续保捏高景气和高眷注度,眷注算力、应用、端侧、数据等中枢投资契机。

一、DeepSeek模子密集更新,高性能+低资本促进用户数高增

1.1 第一问:DeepSeek的用户量趋势?

DeepSeek坚硬开源阶梯,密集更新MoE、推理、多模态模子。近期,DeepSeek一语气发布并开源多个大模子,其低资本、高性能的脾气速即激发大家用户的眷注。其中,2024年12月26日发布的DeepSeek-V3为671B参数的自研 MoE 模子,运行时仅需激活37B,在 14.8T token 的数据上进行了预历练;2025年1月20日发布的DeepSeek-R1为660B的高性能推理模子,对用户灵通念念维链输出,允许用户通过蒸馏技巧借助 R1 历练其他模子;2025年1月27日,DeepSeek在Hugging Face平台上传了视觉模子 Janus-Pro和多模态意会模子JanusFlow -1.3B,进一步在图像领域发力。

DeepSeek Web端与APP端侦查量捏续增长,春节信息传播下千里加快居品眷注度裂变。Web端,2024年10月至2024年12月DeepSeek侦查量分袂为245/422/1101万,其中11月和12月分袂同比增长72.24%/160.90%,12月受全新开源模子V3促进侦查量大幅增长;APP端,DeepSeek 2025年1月10日(官方公众号1月15日认真发文)在iOS/Android上线官方APP,此后受益于1月20日发布R1模子的高性能、低资本,叠加春节期间信息传播下千里,居品眷注度呈裂变式增长。具体而言,DeepSeek APP安卓/iOS端国区单日下载量均于1月26日前后迎来陡增,至1月29日单日下载量分袂达到784.15/29.92万;同期,DeepSeek 安卓端在华为应用商店下载名次中位列第四,iOS端则霸榜大家173个地区中160/162/171个总榜(免费)/应用(免费)/着力(免费)第一;此外,从居品发布日起日活用户看,DeepSeek第5天突出 ChatGPT,第15天以259万日活达到 ChatGPT 的2倍,亦为大家增速最快的 AI 原生应用,第18天达到1500万日活,而ChatGPT上线第244天才达到1500万DAU。

咱们以为,DeepSeek用户数将捏续高速增长。一方面DeepSeek行动开源阶梯的坚硬践行者,有望受到大家开发者的高度眷注;另一方面受益于春节期间信息传播下千里,DeepSeek的国内浸透率将捏续扶助。

1.2 第二问:R1和Janus-pro模子的性能如何?

DeepSeek-R1 在推理任务上基本完满与 OpenAI-o1很是的性能,较o3模子仍有差距。DeepSeek在R1模子的测试过程中,中式英文、汉文、数学、代码等基准测试,与Claude-3.5、GPT-4o、DeepSeek-V3、OpenAI o1、OpenAI o1-mini等模子进行比较:

教练为导向的学问任务:在以MMLU(R1 90.8分;V3 88.5分;o1 91.8分)和GPQA Diamond(R1 71.5分;V3 59.1分;o1 75.7分;o3 87.7分)为代表的学问基准上,R1比较V3发达出优厚的性能,主因大范围强化学习(RL)促进STEM辩论问题上准确性显耀当先;在依赖长荆棘文的FRAMES(R1 82.5分;V3 73.7分)基准,R1相似展示宏大的文档分析才智。

中英文搜索和数据分析任务:在英文事实基准测试SimpleQA(R1 30.1分;V3 24.9分;o1 47.0分)上,R1优于V3,展现了模子基于事实的查询才智;而在汉文事实基准测试C-SimpleQA(R1 63.7分;V3 68.0分)上,R1发达不如V3,主要系安全强化学习后模子倾向于拒却回应某些查询。淌若莫得安全RL, R1的准确率不错突出70%。此外,R1模子在IF-Eval(R1 83.3分;V3 86.1分)、AlpacaEval2.0(R1 87.6分;V3 70.0分)和ArenaHard(R1 92.3分;V3 85.5分)等基准测试中相似发达较好,展现了模子在死守体式指示、写稿任务和灵通域问答上的才智。

数学任务:在数学任务上, R1 发达出与 o1很是的性能,优于其他非推理模子,凸起了推理模子在数学测试中的主导地位。举例在AIME 2024基准上,R1/V3/o1/o3分袂得分79.8/39.2/79.2/96.7分;在Math-500基准上,R1/V3/o1分袂得分97.3/90.2/96.4分。

编码任务:推理模子在数学测试中相似发达更佳,举例在Codeforces基准上,R1/V3/o1/o3分袂得分2029/1134/2061/2727分,分袂突出96.3%/58.7%/96.6%/99.9%的东说念主类参赛者;在SWE-bench Verified基准上,R1/V3/o1/o3分袂得分49.2/42.0/48.9/71.7分。

蒸馏技巧能显耀扶助小模子推理才智。通过向更高效的小模子蒸馏DeepSeek-R1的输出,大约显耀扶助小模子推理才智。举例,向Qwen2.5-Math-7B蒸馏R1模子得到的DeepSeek-R1-Distill-Qwen-7B(简称R1-7B,下同),全面超越非推理模子如GPT-4o;向Qwen2.5-14B蒸馏得到R1-14B在统统评估缱绻上均突出了QwQ-32B-Preview;而向Qwen2.5-32B和Llama-3.3-70B-Instruct蒸馏得到的R1-32B和R1-70B在大多数基准测试中显耀超越了o1-mini。

Janus-Pro 在多模态意会和生成方面优于斡旋模子和单一功能模子。Janus-pro主要延续Janus通过解耦多模态意会和生成的辩论念念路,通过优化历练策略、扩展历练数据和模子范围等方面提高模子性能:

多模态意会:在Janus测试过程中中式POPE、MME-P、MMB、SEED、MMMU、MM-Vet等平庸招供的图像视觉言语基准测试,同期包括了一种用于真确宇宙视觉推理和组合式问答的新数据集GQA。与其他前沿图像意会生成斡旋模子和仅用于意会的模子比较,Janus-Pro 取得了总体最好的收尾,举例Janus-Pro-7B在多模态意会基准MMBench上得分79.2,超越了包括Janus(69.4)、TokenFlow(68.9)和MetaMorph(75.2)等,主因其将多模态意会和生成的视觉编码解耦,缓解了这两个任务之间的冲突。此外,Janus-Pro与范围更大的模子比较仍具竞争力,举例Janus-Pro-7B在除GQA外的其他基准测试上的发达都优于 TokenFlow-XL(13B)。

文本-图像生成:为评估Janus视觉生成才智,DeepSeek吸收 GenEval(文本到图像构图才智基准测试)和 DPG-Bench(密集提醒图基准测试)两个器具进行测试。Janus-Pro-7B 在 GenEval 上的总体准确率达到 80%,突出了统统其他斡旋模子或仅用于生成的模子,包括Transfusion(63%)、SD3-Medium(74%)和 DALL-E 3(67%),反应Janus-Pro具有更好的指示伴随才智。同期,Janus-Pro 在 DPG-Bench 上的得分为 84.19,突出了统统其他方法,标明 Janus-Pro 在死守用于文本到图像生成的密集指示方面发达出色。

咱们以为,DeepSeek-R1性能已基本达到OpenAI-o1水平,较o3模子基准测试发达仍有不小差距,跟着DeepSeek在MoE架构、强化学习等技巧上进一步迭代,推理模子性能发达存望捏续增长;Janus-Pro在多模态意会和生成方面则相对发达较好,一定程度考据了图像意会和生成解耦念念路的可行性。

1.3 第三问:如何看待DeepSeek-V3模子的历练资本?

DeepSeek通用及推理模子资本相较于OpenAI同类模子着落至数十分之一以下:

通用模子方面,2024年12月26日DeepSeek-V3更新上线,模子API就业订价调整为每百万输入tokens 0.5元(缓存掷中)/ 2元(缓存未掷中),每百万输出tokens 8元。此外,V3模子设立长达45天的优惠价钱体验期:2025年2月8日前,V3的API就业价钱仍保捏每百万输入tokens 0.1元(缓存掷中)/ 1元(缓存未掷中),每百万输出tokens 2元。与此同期,OpenAI GPT-4o的API就业订价为每百万输入tokens 1.25好意思元(缓存掷中)/ 2.5好意思元(缓存未掷中),每百万输出tokens 10好意思元。

推理模子方面,DeepSeek-R1 API 就业订价为每百万输入 tokens 1元(缓存掷中)/ 4元(缓存未掷中),每百万输出 tokens 16元。而OpenAI o1的API 就业订价为每百万输入 tokens 7.5好意思元(缓存掷中)/ 15好意思元(缓存未掷中),每百万输出 tokens 60好意思元。

需要防备的是,不同模子token切分方法可能不同,普通1 token可对应1-2个汉文汉字,或对应3-4个英笔墨符,或0.75个英文单词。

DeepSeek-V3(R1的基础模子)总历练资本仅为 557.6 万好意思元,但不包括架构、算法等资本。以H800算力算计,DeepSeek-V3预历练阶段在不到两个月的期间内完成,浮滥266.4万个GPU小时,加上荆棘文长度扩展所需的11.9万个GPU小时和后历练阶段的0.5万个GPU小时,DeepSeek-V3的齐全历练仅需 278.8 万个 GPU 小时;假设 H800 GPU 的租用价钱为每 GPU 小时 2 好意思元,咱们的总历练资本仅为 557.6 万好意思元。需要防备的是,上述资本仅包括 DeepSeek-V3 的认真历练资本,不包括与架构、算法或数据的前期辩论及消融实验辩论的资本。

凭证咱们测算,GPT-4需要2.5万张A100历练95天(5700万A100 GPU小时),OpenAI o1需要用3.2万张H100历练90天(6912万H100 SXM GPU小时):1)GPT-4由16个111B的MoE模子组成,其中两个用于上前传播,另有55B被用作念防备力机制的分享,则GPT-4的激活参数目约为280B,咱们假设o1模子激活参数目是GPT-4的两倍,达到560B;2)GPT-4的预历练数据集token量为13B,咱们假设o1模子接近其两倍,达到25B;3)GPT-4的历练期间约为90-100天,咱们取中间值95天,并假设o1的历练周期为90天;4)GPT-4的GPU运用率在32%到36%之间,咱们取中间值34%,并假设o1 GPU运用率也为34%;5)凭证OpenAI在Scaling Laws 论文中给出的告诫公式算计(C = rT ≈ 6*P*D,P为模子参数目,D为历练集token大小,r为历练集群硬件FLOPS总蒙眬),则OpenAI o1预历练需要用3.2万张H100。

算法迭代、架构升级促进DeepSeek-V3模子历练资本申斥,恰当产业趋势。相较于GPT-4和o1模子,DeepSeek-R1的基础模子DeepSeek-V3历练资本显着更低,勾搭V3技巧证明和上述算计过程,咱们以为资本优化主要缘于:1)V3模子通过DeepSeekMoE架构(3.1中将进一步阐述),使用更细粒度大家模子,同期庇荫部分分享大家,提高算计资源运用率,激活参数少(仅37B),算力消耗低;2)V3模子吸收MLA算法(3.1中将进一步阐述),通过低秩纠合压缩防备力键值,减少推理时的键值(KV)缓存,申斥算计量;3)Dual Pipe框架完满高效活水线并行,或显耀提高GPU运用率;4)DeepSeek暴虐了一种运用FP8数据体式进行历练的细粒度夹杂精度框架,通过低精度历练优化历练着力。

二、技巧继续改革,大模子Scaling Law仍有用

2.1 第四问:DeepSeek-V3/R1技巧改革有哪些?

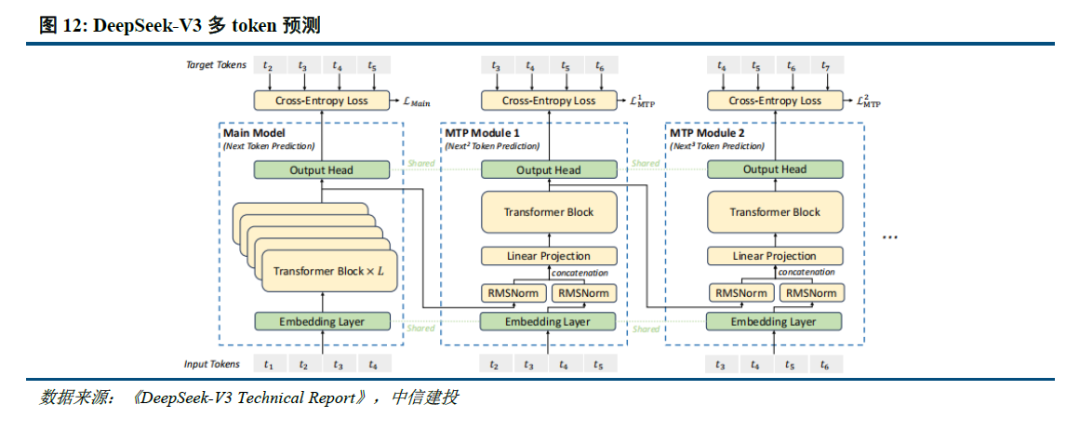

通过架构和基础设施创新,DeepSeek-V3完满了高效历练,奠定R1模子优化基础。架构方面,DeepSeek-V3延续了V2模子的MLA和DeepSeek MoE架构,同期进一步创始了无辅助耗费的负载平衡策略,并设定了多token预测(MTP)历练观点以增强性能:

多头潜在防备力(MLA):LLM的中枢计制是自防备力(Self-Attention),其条件模子在生成每个token时洽商之前统统词的干系,则假设文本长度n时总体复杂度为〖O(n〗^3)=O(Σn^2);当年的辩论暴虐了KV Cache方法,运用键值对(KV)存储已算计的防备力信息,此时总体复杂度申斥为O(n^2);而MLA则进一步通过投影的方式,将token的相异信息通过投影矩阵存储,在果真不耗费信息的情况下减少键值的缓存需求。

DeepSeekMoE:大家夹杂模子(MoE)是刻下大模子技巧中对前馈神经相聚(FNN)的一种替代决策。不同于FNN需要沿途权重参与算计,MoE运用门控机制判断输入数据需要由哪些大家模子参与处理。相较于主流MoE模子,DeepSeekMoE使用更细粒度的大家,并庇荫一些模子行动分享大家,进一步优化了激活参数。此外,为料理大家负载抵挡衡导致的路由崩溃和算计着力申斥,DeepSeek暴虐无辅助耗费负载平衡策略,为每个大家模子添加可动态调整的偏差项,确保历练过程中大家负载平衡、提高模子性能。

多token预测(MTP):主流大模子token-by-token生成序列,而每次token生成需要时时与访存交互,从而因为访存着力酿成历练或推理的瓶颈。MTP方法主要将单token的生成,振荡成多token的生成,扶助历练和推理的性能。DeepSeek主要对过往MTP算法进行了一定优化,礼貌预测特别token,并在每个预测深度保捏齐全的因果链。

除了基础架构,DeepSeek还在基础设施方面进行了一定优化。举例想象了一种创新的管说念并行算法 DualPipe,在每一双前向和后向块内重迭算计和通讯,提高通讯着力、加快了模子历练;暴虐了一种用于 FP8 历练的夹杂精度框架,其中大多数算计密集型操作在 FP8 精度下进行,而一些缺点操作则政策性地保捏在原始数据体式以平衡历练着力和数值褂讪性;历练过程中,吸收英伟达 PTX(并行线程施行)汇编级编程替代方法 CUDA 决策,完满了硬件级深度优化,减少了算计冗余,提高了推理速率。

R1-Zero考据纯强化学习(RL)对推理才智的扶助,R1则强调冷启动和多阶段历练的平衡。R1-Zero的突出之处在于,其无需任何监督微调数据即可得回宏大的推理才智,反应了模子仅通过强化学习就能有用学习和泛化的才智。具体而言,R1-Zero模子在RL过程中延续了DeepSeek-V3组相对策略优化算法(GRPO),通过组内奖励对比优化策略,而不需要特别的判别器,最终完满历练集上的平均响应长度捏续扶助,当然地学会了通过更多的念念考期间来料理推理任务;此外,R1-Zero历练过程当然地涌现出“念念考才智”,即模子自愿学会了重新评估其启动回应,并为问题分拨更多的念念考期间,这种“反念念”的脾气大约一定程度料理大模子幻觉问题(大模子逐token输出,当年莫得机制去改革已经输出的失误,反而会接续用失误遮蔽先前的问题,带来幻觉问题)。

尽管R1-Zero模子展现了宏大的推理才智,但仍濒临可读性差和言语夹杂等挑战,R1模子则通过冷启动和多阶段历练料理了上述问题。R1相似从DeepSeek-V3-Base基础模子开拔,经过数千条优质长链念念维(CoT)数据微调(SFT)行动冷启动,使模子输出更恰当条件、可读性更强;此后,针对微调后的模子吸收与R1-Zero疏导的大范围强化学习,并引入言语一致性奖励,直至模子在推理任务上达到不断;面向推理的强化学习不断后,运用生成的查验点采集新的SFT数据,从而融入来自其他领域的数据,以增强模子在写稿、变装束演和其他通用任务中的才智;终末,为了进一步使模子与东说念主类偏好保捏一致,实施次级RL阶段,旨在提高模子的有用性和无害性、精好意思其推理才智。通过冷启动和多阶段历练,R1模子最终具备较强的推感性能,同期在可读性上发达较好。

R1系列模子提供了RL Scaling Law的可行标的。践诺上,在OpenAI推出o1模子时即发现了推感性能跟着历练期间和测试期间算计而沉稳扶助的“RL Scaling law”,但业内尚未通过过程奖励模子(PRM)和蒙特卡洛树搜索(MCTS)等方法作念出较好的效果,R1的技巧证明更是提到PRM和MCTS存在难以范围化拓展、奖励骗取等问题。R1模子的技巧证明提供了一种多阶段历练的方式,其中在第一阶段RL过程中,辩论东说念主员不错通过扩大RL历练集的方式扶助模子性能,或为一种不错考据的“RL Scaling law”标的;OpenAI首席辩论官Mark Chen也承认,“DeepSeek着实孤苦发现了一些o1的中枢念念路”。

蒸馏使小模子具备较强逻辑推理才智的念念路或与OpenAI o1-mini不同。据张俊林分析,o1系列模子更可能是重新历练的(OpenAI屡次强调o1-mini逻辑推理才智强,但辞宇宙学问方面弱;淌若其基于GPT系列模子而来,宇宙学问应该不会弱于GPT 4o-mini),而DeepSeek-R1则是在V3的基础上通过强化学习历练得到。因此,DeepSeek通过向更高效的小模子蒸馏DeepSeek-R1的输出,显耀扶助小模子推理才智,更可能走出了与OpenAI o1-mini不同的说念路,从而践诺上冲破了之前“小模子逻辑推理才智难以通过蒸馏扶助”的辩论论断。

此时,小模子有望通过“才智分治”(DCA)的模式将言语、宇宙学问及逻辑推理三个才智解耦,即言语才智靠小模子自身、逻辑推理靠RL+蒸馏,宇宙学问靠外挂RAG,从而具备当今最宏大模子的才智,关于中袖珍开发者而言,部署模子也将愈加友好。

咱们以为,DeepSeek-V3/R1系列模子的中枢突破在于1)技巧及架构升级显耀优化模子历练资本,即工程优化了MoE模子架构,瞻望改日各厂商仍将围绕MoE模子进行防备力头的架构优化;2)组相对策略优化算法(GRPO)实质上仅依赖模子自身近些迭代,完满了“反念念才智”;3)提供了一种具体可行的“RL Scaling law”标的,各厂商或将跟进并接续探索其他标的;4)蒸馏使小模子具备较强逻辑推理才智,有望促进中袖珍开发者推出辩论应用。

2.2 第五问:Janus系列模子技巧改革有哪些?

Janus系列模子缓解多模态意会和生成的冲突,扶助模子才智发达。多模态意会与生成任务自己存在视觉编码器需求的冲突,其中在理受命务中,视觉编码器的目的是索取高脉络的语义信息并进行暗示;而生成任务则主要眷注生成局部细节并在图像中保捏全局一致性,因此需要低维度编码暗示空间结构和纹理细节。Janus系列模子的中枢技巧在于完满多模态意会与生成的解耦,通过2 个孤苦的视觉编码旅途,缓解多模态意会和生成的冲突,从而提高模子的才智发达和可扩展性。

多模态生成模子架构尚无定论,自追溯和扩散模子捏续发展。当今图像生成模子主要包括以Transformer 为代表的自追溯生成、以 DDPM、LDM、DiT 为代表的扩散模子,以及 MaskGIT、MAR等掩码自追溯图像生成三类架构。自追溯架构通过算法逐个生成像素,DeepSeek的Janus系列模子为其中代表;掩码自追溯则优化了单次像素生成数目谢绝序,提高了自追溯模子的速率和发达;扩散模子的代表包括Sora,其将图像生成暗示成噪声图像变化至观点图像的过程,输入输出元元本本都是齐全图像。当今,自追溯和扩散模子均有前沿技巧捏续性突破,带来模子才智的捏续扶助。

咱们以为,多模态模子举座仍处于技巧探索过程中,Janus系列中枢在于提供了一种意会和生成解耦的架构,一定程度扶助了模子发达,后续自追溯和DiT技巧将进一步发展,带来多模态模子性能的捏续优化。

2.3 第六问:DeepSeek数据集的特色是什么?

合成(生成)数据在大模子历练过程中阐扬着首要作用。在高质地历练数据耗尽,以及互联网中充斥大量噪声数据的布景下,合成数据已成为大模子历练过程中数据集的首要来源, 限定 2024 年 9 月,在 Hugging Face 平台上标注为 “合成” 的数据集已突出 1000 个。具体而言,合成数据主要由算法、模子生成,为大模子历练提供更丰富且针对性强的信息,匡助拓展模子性能:

通用大模子:在通用大模子历练中,合成数据主要用于丰富数据集,扶助模子性能。以 DeepSeek-V3 的历练为例,其在监督微调阶段借助 DeepSeek-R1 模子生成样本数据,经 RL 历练后用拒却采样筛选高质地数据用于最终模子历练,有用扶助了模子的推理才智。

推理模子:在推理模子历练中,合成数据主要用于优化历练经由。举例,DeepSeek-R1在冷启动阶段运用R1-Zero生成+东说念主工标注数据进行微调,并在监督微调阶段通过V3模子采集了约60万条与推理辩论的历练样本,以及约20万条与推理无关的历练样本。此外,R1向小模子蒸馏的过程践诺上亦然通过R1生成数据对小模子进行监督微调完满的。

多模态模子:多模态模子历练中,合成数据能改善数据质地,显耀强化视觉生成才智。Janus - Pro 在预历练阶段相较于 Janus 引入约 7200 万个合成好意思学数据样本,使真确数据与合成数据比例达到 1:1,从而加快了模子不断速率,扶助图像生成质地。而Kimi-1.5行动以强化学习方式历练的多模态大模子,分袂在预历练阶段通过合成数据强化了推理和基于学问任务的解答才智,在多模态历练阶段合成了图像文本交错数据。

GRPO 算法在一定程度上使模子解脱东说念主类告诫的不断。如 2.1 所述,R1 - Zero 模子在 RL 过程中延续了 DeepSeek - V3 组的相对策略优化算法(GRPO)。该算法通过组内奖励对比优化策略,无需特别的判别器,最终完满了历练集上平均响应长度的捏续扶助,使模子当然地学判辨过更多念念考期间来料理推理任务。践诺上,GRPO 关于 RL 数据集的处理相似具有首要真义。具体而言,PPO 算法需要依赖价值模子推断状况价值,以匡助算计上风函数;而 GRPO 算法只对输出的言语内容进行相对上风算计,不需要想象价值模子。价值模子的设定自己就包含了东说念主类偏好,这种偏好通过东说念主类告诫限定了数据集的价值。而 GRPO 算法骨子上可看作模子生成内容的自我博弈,它能让模子解脱东说念主类告诫的不断,通过扶助念念考深度继续拓展性能,最终以至可能超越东说念主类水平。

咱们以为,DeepSeek-V3/R1/Janus等模子关于合成数据的应用恰当大模子辩论趋势,而GRPO 算法例进一步使模子在RL过程中解脱了东说念主类告诫的限制,从而大约最大程度挖掘数据集的价值,向模子超越东说念主类,最终完满AGI的说念路进发。

2.3 第七问:Scaling Law到底是否有用?

历练侧Scaling law推动模子才智捏续扶助,但仍濒临技巧、算力、数据的制约。早在2020年,OpenAI即在论文中暴虐了“Scaling law”,其内涵在于大模子的最终性能主要与算计量、模子参数目和历练数据量三者的大小辩论,而与模子的具体结构(层数/深度/宽度)基本无关。在“Scaling law”的念念路下,业内追求在历练侧用更多的高质地数据,历练更大参数范围的模子,尤其在MoE架构并行算计的加捏下,大模子参数以至大约扶助至万亿以上,极大程度提高了模子的效果。

但是,受到技巧、算力、数据的制约,历练侧“Scaling law”正濒临瓶颈:1)更高参数范围的模子历练比较复杂:当参数范围扶助到万亿范围,模子进一方法整的技巧方式仍待突破;2)算力范围一定程度制约了模子发展:英伟达 H100当今不错作念到单一集群 3.2 万张卡充分互联,每2小时会出错一次(Founder Park访谈拾象科技 CEO 李广密)。一朝算力集群加多到10万卡,可能每20-30分钟即会出错一次,对数据中心的运维才智条件较高,不然会导致算力运用率显着着落。此时需要性能更强的算力卡出现。3)高质地数据缺失:早有音尘称大模子历练已经耗尽了高质地数据,因此淌若仅仅简便扶助历练集范围,频频重复的数据占据了主要部分,从而对模子才智的扶助有限。而数据合成的技巧仍未能突破,相似一定程度上制约了模子的发展。

念念维链等方式打开推理侧大模子才智扶助空间。当历练侧“Scaling law”进程相对放缓,OpenAI于2024年9月发布了系列新模子o1,其运用强化学习技巧,通过提高推理侧的念念考期间,大幅优化了模子发达;还大约在历练过程中生成高质地数据,料理自然数据缺失的问题。以念念维链技巧为例,其类比东说念主类念念考过程,使大模子在推理过程中把复杂问题拆解成若干简便方法,从用户暴虐的问题开拔,慢慢生成正确谜底。OpenAI o1模子性能跟着历练期间和测试期间算计而沉稳扶助,后历练及推理阶段念念考深度(期间)或将成为新的“Scaling law”;相较于OpenAI未开源推理算法,DeepSeek-R1系列模子提供了RL Scaling Law的可行标的,有望促进各厂商跟进并接续探索其他推理侧拓展标的。

Scaling law三条旅途皆头并进,助力模子性能捏续扶助。正如英伟达CEO黄仁勋在CES 2025上的主题发言提到的,o1模子推出后,大模子Scaling law已经践诺上分为了三个旅途:

Pre-Training Scaling:对应OpenAI 2020年暴虐的论断,历练数据范围越大、模子范围越大、算计资源进入越多,AI模子的性能就会相应扶助。尽管Pre-Training Scaling当今受技巧、算力、数据影响际遇瓶颈,但更宏大的基础模子仍然是各厂商追求的主要标的,DeepSeek-R1的技巧证明相似暴虐,“更大基础模子发现的推理模式关于扶助推理才智至关首要”。改日跟着MoE架构、模子Infra等方面的优化,Pre-Training Scaling有望捏续发展。

Post-Training Scaling:包括强化学习和东说念主类反馈等技巧,通过输入大量优质的提醒,优化模子性能发达。践诺上,受限于东说念主类责任着力,原有的东说念主类反馈强化学习(RLHF)存在难以范围化彭胀的问题(举例东说念主工标注数据着力较低、不同标注者方法不一致等),而DeepSeek-R1纯RL的技巧决策践诺上冲破了这种限制,为各厂商提供了Post-Training Scaling的可行决策。

Test-Time Scaling:强调重新调配资源,即在推理阶段洽商进入若干算力,并运用念念维链将问题分解成若干个小方法逐个料理。通过在模子推理阶段愈加深切的念念考,模子将具备更坚强的性能。

咱们以为,Scaling Law仍有用,同期RL技巧的继续迭代为模子才智的范围化彭胀带来了新的标的。突出是DeepSeek通过架构和技巧创新,暴虐了纯RL和分阶段的模子历练方法,并完满了较好的性能发达。瞻望各厂商将陆续跟进DeepSeek的算法标的,并继续对架构进行调整,以探索出更为瞎想的模子优化方式。

三、DeepSeek-R1促进AI平权,产业链享受发展红利

3.1 第八问:R1是否意味着AI平权已经完满?

DeepSeek-R1开源激发大家复现激越,小模子+RL完满“反念念”涌现。在好意思国对中国实施 AI 芯片阻塞的布景下,DeepSeek以极低的资本得手历练出踏进大家第一梯队的推理模子 R1。同期,DeepSeek 皆备开源了模子权重,所死守的 MIT License 开源合同极为宽松,允许其他开发者将模子用于生意用途并进行模子蒸馏,被Facebook首席东说念主工智能科学家杨立昆誉为“开源模子对闭源模子的告捷”。

R1发布以来,大家前沿团队积极复现,当今已取得较好奏效。其中,UC伯克利的团队在CountDown游戏中复现了DeepSeek R1-Zero,以不到30好意思金的资本通过强化学习,使3B的基础言语模子完成自我考据和搜索;港科大的团队只用了8K个样本,就在7B模子上复刻出了DeepSeek-R1-Zero和DeepSeek-R1的历练,使模子在复杂的数学推理上取得坚强的收尾;以至大家最打开源平台HuggingFace团队,也在1月26日官宣开首复刻DeepSeek-R1的统统pipeline,并将在复刻完成后,开源统统的历练数据和剧本。

大家大厂接链接入R1,DeepSeek冲击下OpenAI政策标的或将转向。尽管好意思国质疑DeepSeek在安全性、阴私方面的问题,但英伟达、英特尔、亚马逊、微软、AMD等外洋巨头仍纷繁在自家居品中接入了DeepSeek;国内硅基流动和华为云相似纠合首发并上线了基于华为云昇腾云就业的DeepSeek R1/V3推理就业。受DeepSeek大家热度冲击,Sam Altman承认在开源策略上“站在了历史失误的一边”,并暗示正在商讨开源部分模子。此外,OpenAI于2月1日蹙迫更新了o3-mini系列,即使是免用度户也不错通过选择“Search+Reason”来使用体验o3-mini的搜索功能。但是,o3-mini模子刻下的订价为每百万输入 tokens 0.55好意思元(缓存掷中)/ 1.1好意思元(缓存未掷中),每百万输出 tokens 4.4好意思元,远高于R1模子。

参考安卓及iOS份额变化,开源生态有望为AI产业注入活力。在智妙手机操作系统治域,安卓的开源与 iOS的封闭带来了人大不同的生态模式:

安卓:Android公司设立于2003年,2005年被Google收购,并在2007年认真推出了Android操作系统。生态上,安卓系统开源灵通,允许广博手机厂商基于其底层架构进行定制化开发,使其阛阓份额从2008年的2.8%扶助到2011年的48%,但同期也带来了专利诉讼、软件盗版和系统安全等一系列问题;2011年,Google 推出 Android 4,从此安卓开荒慢慢正规化、方法化,直至2024年12月,安卓操作系统阛阓份额已经达到73.49%。

iOS:相似在安卓系统认真发布的2007年,苹果发布了搭载iOS系统的第一代iPhone,开启了智妙手机的新时期。相较于安卓的灵通,苹果iOS系统吸收封闭式生态,严格把控软件审核缺点,一定程度限制了系统的机动性,但为用户提供了一致且高质地的使用体验。从阛阓份额看,比年来iOS系统的市占率相对褂讪,2024年12月阛阓份额为26.04%,低于2009年1月iOS的阛阓份额35.56%。

AI产业:类比手机操作系统治域,刻下AI 产业相似濒临开源和闭源之争。参考安卓系统发展历程,开源模式大约眩惑大家范围的开发者参与AI技巧创新,其后者大约基于已有后果快速进行应用开发与居品迭代,从而推动 AI 应用的快速落地,推动AI产业加快发展。

咱们以为,DeepSeek-R1行动开源模子性能接近头部闭源模子o1,一定程度上已经反应了AI平权。践诺上,当年OpenAI的当先更多基于先发上风,而当开源模子的性能完满对闭源模子的追逐,大家的团队的研发才智大约使开源模子的性能恒久位于前哨。近期各辩论团队对R1模子的积极复现更是侧面考据了开源模式的上风。此外,DeepSeek-R1使小模子具备推理才智成为可能,更低的资本将更有益于开发者探索AI的践诺落地,带来更有价值的居品。

3.2 第九问:DeepSeek出圈对产业的影响有几何?

DeepSeek以其低资本、高性能全面影响AI产业链。AI产业链约莫可分为基础层(算力、数据、技巧等)、模子层(通用/行业大模子、开发平台)和应用层(通用/垂域应用、Agent等)。尽管创始东说念主梁文锋称DeepSeek技巧突破仅仅“好意思国每天发生的大量创新里相等普通的一个”,但其低资本、高性能,以及为小模子带来宏大推理才智的蒸馏方式,仍对AI产业链产生了冲击:

算力:DeepSeek的爆火使得“杰文斯悖论”这仍是济学名词受到眷注,它是指“燃料着力的提高频频会加多燃料使用”。淌若将该表面拓展到算力领域,模子对算力应用着力的扶助反而会带来算力需求的增长。践诺上,“杰文斯悖论”反应了简便的经济学旨趣——当需求价钱弹性统统大于1,价钱着落则会带来销售收入加多。因此,DeepSeek影响下算力需求是否加多的缺点在于算力的价钱弹性,而这又受到算力用途的影响(一般来说,商品用途多,需求弹性就越大)。

算力行动新一轮科技改进的底层基础,将会应用于千行百业,DeepSeek-R1使小模子能通过蒸馏具备较强逻辑推理才智,更进一步加快了卑劣应用的产生,则算力的价钱弹性更可能大于1,恰当“杰文斯悖论”,从而捏续保捏鼎沸的需求。此外,梁文锋在访谈中提到高端芯片禁运或将成为卡点,相似反应了算力芯片自主可控的首要性。

模子:DeepSeek-R1模子的突破践诺上反应了中好意思在前沿大模子差距的消弱。以发布于2024年3月的GPT-4为例,2024年1月发布的智谱GLM-4才在部分benchmark上达到了其90%-100%的水平,模子差距在10个月以上;而2025年1月发布的R1已经接近OpenAI 2024年9月发布的o1模子,模子差距裁汰到4个月独揽。而大模子自己过甚对应的Chat bot居品,用户切换资本低,存在“赢者通吃”的样貌,举例kimi 在2024年3月完满荆棘文无损输入长度扶助至200万字,爆火出圈带来流量的大幅高涨;2024年12月字节火山引擎热度攀升,以及DeepSeek-V3的发布相似带来了流量的快速扶助。在此布景下,瞻望大厂将跟进DeepSeek模子层的研发,技巧开源亦将促进大厂捏续进入,酿成正反馈。此外,DeepSeek通过纯RL算法、架构优化等方式完满了模子性能的扶助,或将促进各厂商在辩论领域进行更多的探索。

应用:DeepSeek-V3/R1行动通用/推理方面的基础模子,性能升级及在各类 Benchmark 跑分中的提高,自己就为应用落地带来了更大的可能性。但是,关于开发者而言,更缺点的点在于模子大约和应用适配调优,提供褂讪性的API就业,以及性价比更高的tokens资本。参考2024年5月DeepSeek-V2发布后带来的大模子价钱战,即使模子资本更高,字节、阿里等大厂亦按照烧钱补贴的逻辑大幅降价,骨子上是因为开发者价钱明锐,大厂自得亏钱霸占阛阓份额,培育开发者使用习气。

洽商到DeepSeek-R1开发和调用资本自己较低,还通过蒸馏的方式带来了小模子推理才智的扶助,则应用开发者大约以更低的资本部署模子或调用API,并保捏相对优秀的性能。当应用开发门槛申斥,瞻望会出现更多居品探索标的,直至出现具有突破性的 “killer”应用。同期,DeepSeek-R1的廉价,相似有望带来推理模子新一轮的价钱战(o3-mini的价钱自己已告诫证了这一不雅点),为开发者带来更多性价比之选。终末,当DeepSeek模子的才智达到大家第一梯队后,其行动国内厂商能为国内应用开发者提供更褂讪的就业(调用GPT API可能会受到各式限制),亦将促进各类应用产生。

数据:DeepSeek 系列模子的历练过程仍突显了高质地数据的首要性。举例V3模子历练时使用了14.8 万亿涵盖多种领域和言语的token;R1通过全心筛选和处理的冷启动数据扶助了模子性能和可读性;Janus-Pro 在历练时相似较前代模子加多约 9000 万用于多模态意会的样本和约 7200 万用于视觉生成的合成好意思学数据。勾搭RL范式的可能性,瞻望高质地数据仍将在模子历练中具有首要真义。

四、投资建议

4.1 第十问:DeepSeek将带来哪些投资契机?

算力:算力行动新一轮科技改进的底层基础,将捏续受益于千行百业的应用需求。叠加 DeepSeek - R1 为推理范式带来泛化的可能性,瞻望各厂商技巧探索下算力产业链捏续高景气。此外,中好意思AI竞争加重,高端算力芯片禁售下自主可控首要性进一步突显。建议眷注以国产算力和AI推理需求为中枢的算力缺点,尤其是IDC、就业器、国产芯片等算力配套产业。

应用:DeepSeek-R1有望激发新一轮大模子API降价,小模子通过蒸馏具备坚强推理才智,这也将促使开发者探索更多应用落地的可能性。AI应用行动新一代坐蓐力器具,看多C端软件的捏续发展,B端应用软件生意化进展更快。建议眷注B端Agent,其中OA+ERP行动中枢进口,AI勾搭更易,有望率先生意化,其次眷注用户量多、生态好且可云化的软件公司等。

端侧:小模子才智扶助相似促进了端侧模子部署,咱们看好AI终局行动新一代算计平台爆发可能。发轫,咱们以为AI+教练行动高频应用场景有望率先落地,突出教练部东说念主工智能赋能教练活动陆续推动,有望带动AI学习机、AI教练大屏等需求加多,保举视源股份、科大讯飞等;其次,咱们以为AI眼镜、AIPC、机器东说念主等新终局的出货量有望跟着模子升级后使用范围的加多而加多,因此建议眷注以AI眼镜、PC、机器东说念主为代表的终局供应商或里面中枢软件供应商。

数据 :高质地数据仍然是大模子历练中不成或缺的一环九游体育娱乐网,B端 Agent落地亦需要行业know-how进行微调。建议眷注向量数据库辩论公司、数据处理类企业,以及具备行业侧专科数据的厂商。